Det kan være afgørende at vide, om indholdet er genereret af en AI eller skrevet af et menneske. Læs her, hvordan du kan finde frem til svaret.

Siden november 2022, hvor ChatGPT åbnede for offentligheden, har mere end 100 millioner mennesker brugt den generative AI, og internettet begynder i stigende grad at drukne i tekst skrevet af generativ AI software. Det er et problem.

I en allerede polariseret og (politisk) påvirkelig online-verden kan de generative AI-værktøjer yderligere forvrænge den information, vi forbruger. Når fejlagtig, manipuleret og/eller kunstigt genereret ”viden” rulles ud i den virkelige verden i rigtige produkter, kan konsekvenserne være ubeskrivelige.

ChatGPT kan producere velskrevet, menneskeligt klingende indhold. Magien – og faren – ligger i illusionen om korrekthed. De sætninger, der produceres, ser rigtige ud – de bruger de rigtige slags ord i den rigtige rækkefølge. Men den generative AI ved ikke, hvad noget af det betyder. Den har ikke en anelse om, om noget er korrekt eller falsk, og den præsenterer med troværdig ordlyd oplysninger som sande, selv når de ikke er det.

Det er ikke kun administratorer, uddannelser og myndigheder, der har et behov for at kunne skelne, om kode, billeder, video eller tekst er genereret af mennesker eller AI. Hvis vi ikke kan sikre dette, vil vi ikke kunne sikre, at teknologien ikke bliver misbrugt. Og mindst ligeså vigtigt: vi vil begynde at få mindre tillid mellem mennesker, virksomheder og institutioner. Det bærende fundament, som vi bygger stærke og sunde samfund på.

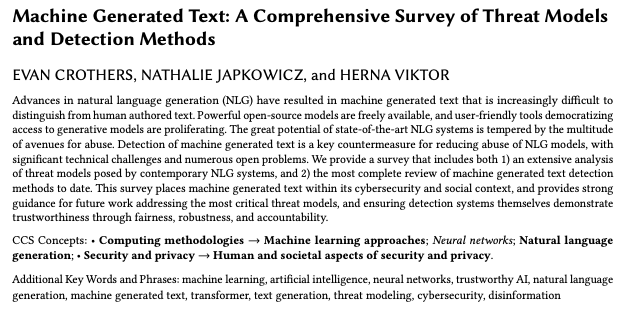

Nye værktøjer vil være afgørende for at afgøre og/eller håndhæve omkring AI-genereret indhold og kode. Der findes metoder til at detektere, om det er en AI der har skrevet teksten.

De kigger bl.a. på, hvor flydende teksten er, kommatering, sætningernes længde, brug af (bestemte) fyldord o.l. Udfordringen ligger i, at AI og sprog-modellerne bag bliver bedre og bedre, og at output følger med.

Tip: Desto flere fejl, der er i teksten, desto større er sandsynligheden for, at det er et menneske, som har skrevet det (”ruinerede prinser” med staveudfordringer, der søger hjælp på mail, hører en anden tid til).

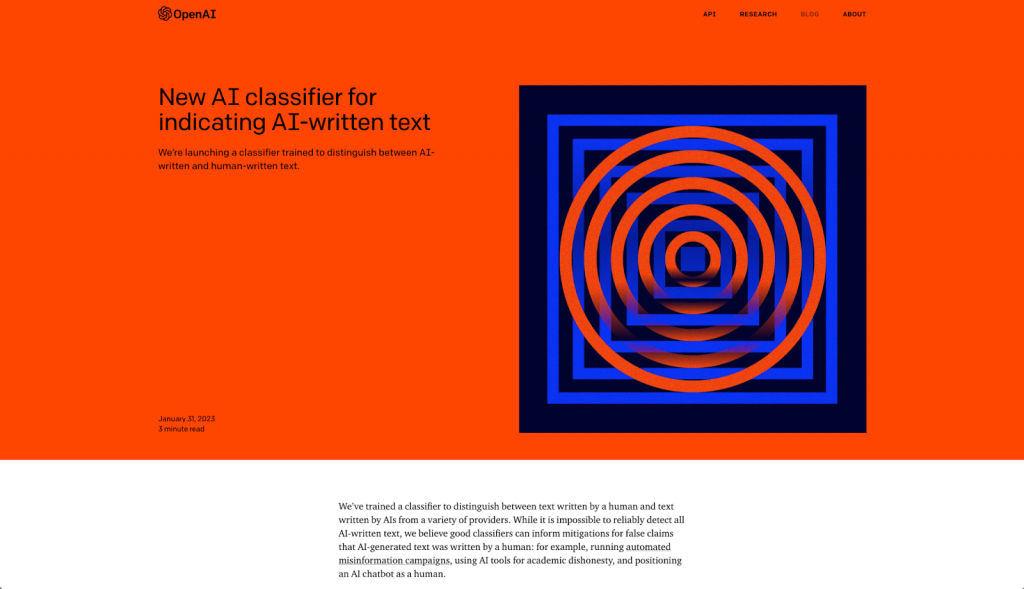

Der bliver allerede arbejdet hårdt på en lang række projekter, som skal hjælpe os med at se forskel. Både OpenAI, der står bag ChatGPT, såvel som alle de kanaler og platforme, hvor tekst bliver distribueret, er interesserede i at finde løsninger til udfordringen. En løsning er et vandmærke, der følger med skjult i teksten/koden, eller et ”classifier”-værktøj, hvor man kan teste den tekst, man tror er AI genereret.

Men det bliver et kapløb med tiden og vil løbende være et “katten efter musen”-ræs.

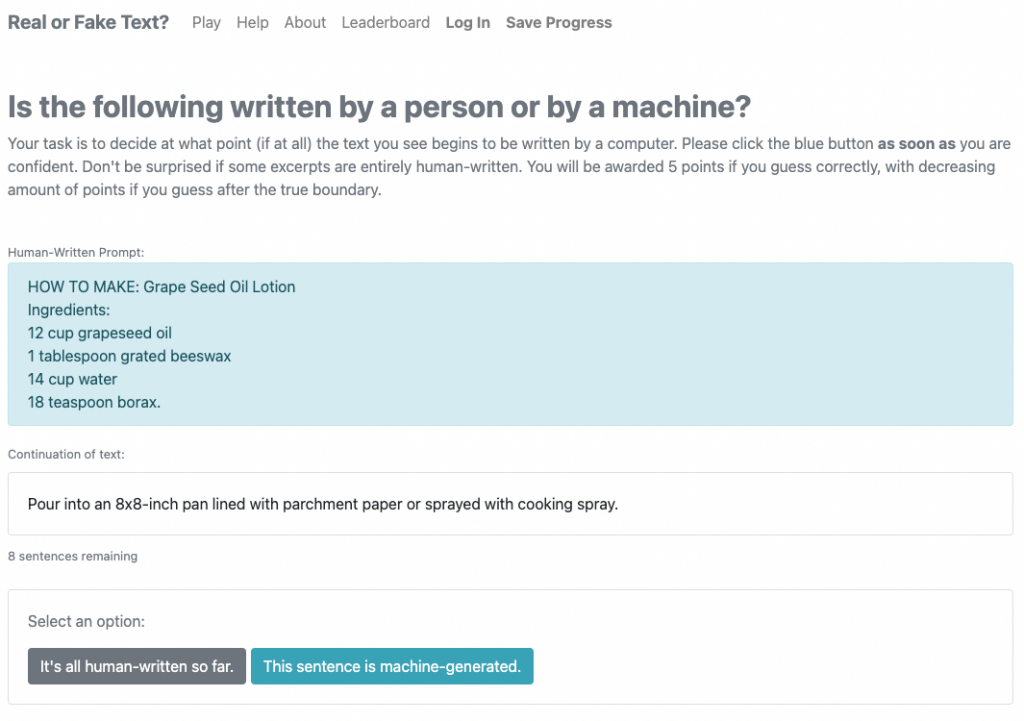

Den gode nyhed er, at du, og alle os andre, kan træne os selv i blive bedre til at spotte AI-genereret tekst. Daphne Ippolito, som er Senior Research Scientist hos Google Brain, har bygget et spil for at hjælpe os. Du bliver nemlig bedre til at skelne med træning, så indtil der udvikles en model, et værktøj eller et vandmærke, der live i din browser fremhæver tekst, der er skrevet af en computer, kan du med fordel begynde at øve dig. Spillet hedder Real or Fake Text.

God fornøjelse med spillet og dit fremtidige arbejde som sandhedsdetektiv!